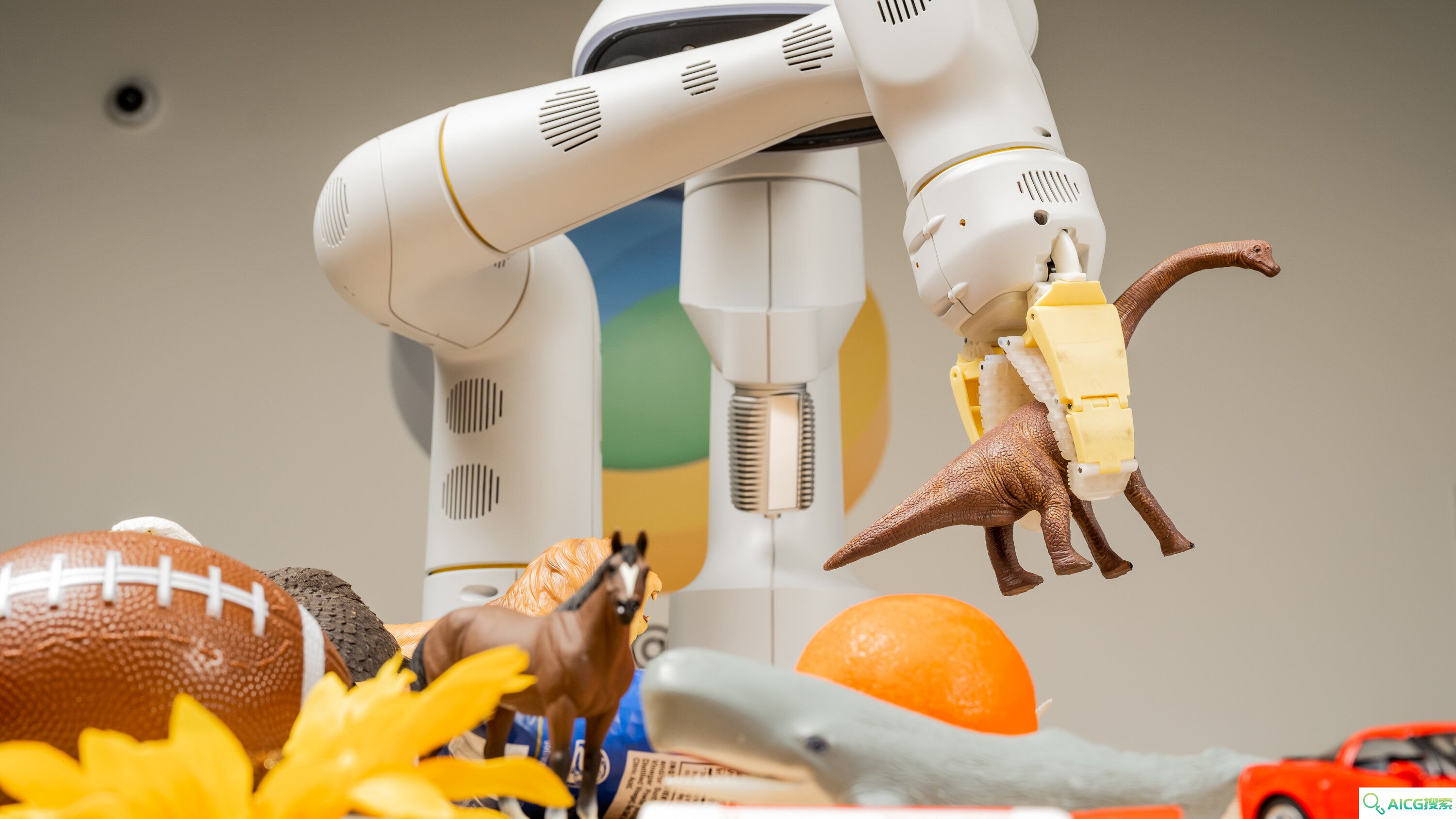

AI奇点网2023年7月31日报道丨7月28日,谷歌推出了一种新的人工智能(AI)模型 Robotics Transformer2(RT-2),可以帮助训练机器人理解扔*等任务。谷歌表示,RT-2 是一种视觉语言动作模型,可将互联网上采集的信息和图像转化为机器人可理解的动作,从而帮助提升机器人的学习能力。

虽然像捡*这样的任务对于人类来说听起来很简单,但机器人需要了解一系列知识后才能学习。例如,机器人必须首先能够识别哪些物品构成*,然后要知道如何将其捡起来并扔掉。

RT-2 允许机器人使用来自网络的知识来帮助它理解如何完成任务,而不是为机器人编程来完成这些特定的任务。即使机器人没有明确地接受过确切步骤的训练,也能通过 RT-2 学会完成新的任务。据外媒报道,谷歌近期没有计划发布或销售采用这项新技术的机器人,但最终这项技术或许可以用于仓储物流或家庭助理机器人。

言之画

言之画 千笔 — AIPaperPass论文写作平台

千笔 — AIPaperPass论文写作平台 万兴爱画

万兴爱画 BlackBox AI,代码生成

BlackBox AI,代码生成 文心一格

文心一格 CodeWhisperer

CodeWhisperer open-assistant.io

open-assistant.io co:here---代码生成工具

co:here---代码生成工具 Stable Zero123

Stable Zero123 访问电脑版

访问电脑版